生成AIガバナンス・構築支援

Governance & Rules

安全かつ効果的なAI活用のための、社内ルール策定とガバナンス体制の構築を支援します。

単なるテンプレートの適用ではなく、貴社の文化や事業特性に合わせて「共に考え、創る」プロセスを重視します。

こんなお悩みありませんか?

- 生成AIを導入したいが、リスクが怖くて進まない

- 従業員が勝手にChatGPTを使って情報漏洩しないか心配

- 他社のガイドラインをコピーしたが、実態に合っていない

- 「禁止」ばかりのルールで、現場の活用が進まない

「ただ禁止する」のではなく、「安全に使い倒す」ためのガードレールを構築します。

企業の文化や業種に合わせ、実効性の高いルールと体制を提供します。

1. 生成AI利用ガイドラインの策定

雛形の使い回しではなく、貴社の業務実態や既存の就業規則・セキュリティポリシーと整合性の取れた、「守れる・使える」ガイドラインを策定します。

許可ツール(ChatGPT等)と禁止ツールのホワイトリスト化。

機密情報・個人情報・公開情報のランク分けと入力可否の明確化(Lv.1〜Lv.3)。

「商標を含む生成物の商用利用」「未検証での顧客提供」など具体的なNG行動を定義。

違反時報告ルートや新規ツール申請フローの設計。

安心ポイント

「他社のコピペではなく、自社の実情(リモートワーク比率や使用デバイスなど)に合わせたルールを作るため、現場が迷わず運用できます。」

2. セキュリティ・リスク評価と対策立案

技術的な設定ミスや、予期せぬ情報流出ルート(Shadow AI)を洗い出し、物理的・システム的な穴を塞ぎます。

全ツール・全アカウントでの学習拒否設定を確認・代行。

IT部門と連携し、個人アカウントでの業務利用状況を調査。

悪意ある攻撃への耐性テストと対策プロンプトの実装。

SaaSに組み込まれたAI機能のリスクを評価。

安心ポイント

「『学習させない設定』の徹底はもちろん、システム的な抜け穴を専門家の視点で塞ぐため、意図しない情報流出を極小化できます。」

3. 従業員向けコンプライアンス研修

どんなに立派なルールを作っても、使う人間が理解していなければ意味がありません。「なぜダメなのか」を腹落ちさせる教育を行います。

情報流出や著作権侵害の実例を紹介し、当事者意識を醸成。

AIに嘘をつかせるデモを通じ、人間の確認が必須であることを体感。

「有名キャラに似た絵」等がなぜ危険かをビジュアルで解説。

研修後のテスト実施と、合格者へのID発行フローの提案。

安心ポイント

「『便利さ』だけでなく『怖さ』も正しく理解してもらうことで、従業員一人ひとりが『ヒューマン・ファイアウォール(人間による防御壁)』として機能するようになります。」

4. 著作権・個人情報保護法対応

変化の激しいAI関連法規制の最新動向に基づき、コンプライアンス遵守を支援します。

※個別具体的な紛争対応は弁護士法に抵触するため、一般的解釈の提供や提携弁護士との連携となります。

「学習は緩いが生成利用は厳しい」という現状の法解釈を業務フローに反映。

入力可能な個人情報の範囲や、第三者提供該当性へのアドバイス。

著作権発生の有無を踏まえた契約書・利用規約への記載事項を助言。

法改正や新ガイドラインが出た際の「影響レポート」を提供。

安心ポイント

「曖昧なネット記事の情報ではなく、文化庁や内閣府の最新公式見解に基づいた『現在最も安全な解釈』を提供し、企業の法的リスクをコントロールします。」

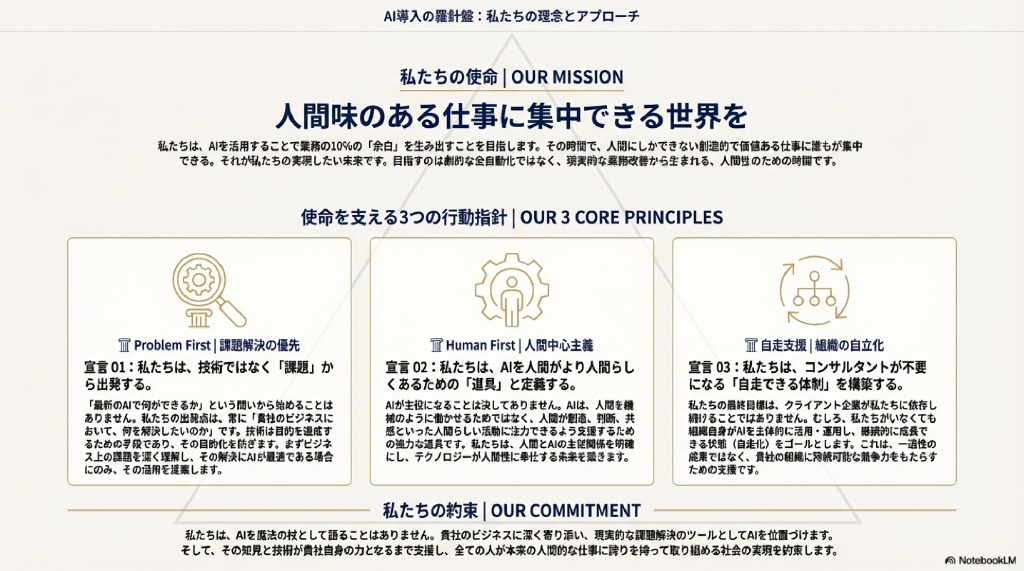

特徴:共に考え、創る

AIガバナンスに「正解」はありません。企業の規模、業種、文化によって最適なルールは異なります。 私たちは、一方的にルールを押し付けるのではなく、経営層や現場の皆様と対話を重ね、 「なぜそのルールが必要なのか」「どうすれば守れるのか」を共に考えます。

イノベーションを阻害しない「攻めと守り」のバランスを重視し、 形骸化しない、生きたガバナンス体制の構築をサポートします。